Le fichier robots.txt sert à indiquer aux robots d’indexation des moteurs de recherche les pages qu’ils doivent ignorer lors de leur exploration du site Web. Le fichier est placé à la racine du site et porte généralement le nom «robots.txt». Les moteurs de recherche respectent strictement les directives figurant dans ce fichier.

Par exemple, si un site contient une page répertoriant les prix des produits en vente, il peut indiquer aux robots d’indexation de ne pas explorer cette page afin qu’elle ne soit pas incluse dans les résultats de recherche. En général, les administrateurs Web utilisent le fichier robots.txt pour empêcher les robots d’indexation d’accéder aux pages qui ne doivent pas être rendues publiques, telles que les pages de connexion ou celles contenant des informations sensibles.

Ajouter le sitemap dans le fichier robots.txt

Il est important d’ajouter votre sitemap à votre fichier robots.txt afin d’aider les moteurs de recherche à indexer votre site plus efficacement. Le plan du site est une liste de toutes les pages de votre site Web, et il peut être utile pour les moteurs de recherche de disposer de ces informations lorsqu’ils parcourent votre site.

Pour ajouter votre sitemap dans votre fichier robots.txt, il vous suffit d’ajouter la ligne suivante :

sitemap: https://votre site.com/sitemap.xml

L’attribut Disallow dans le fichier robots.txt

L’attribut Disallow est utilisé dans le fichier robots.txt pour indiquer aux robots des moteurs de recherche quelles parties du site ne doivent pas être indexées. . Vous pouvez également utiliser l’attribut Disallow pour empêcher les robots d’accéder à des fichiers qui ne sont pas destinés à être lus, comme les fichiers PDF.

Par exemple, pour empêcher les robots d’accéder à la page de connexion, vous pouvez ajouter la ligne suivante au fichier robots.txt :

Disallow: /login.html

Faut-il adapter son fichier robots.txt pour tous les moteurs de recherche ?

Il est important de noter que chaque moteur de recherche utilise ses propres algorithmes pour lire et interpréter les fichiers robots.txt. Par conséquent, il est recommandé d’adapter son fichier robots.txt en fonction des moteurs de recherche que vous souhaitez cibler.

Si vous ne le faites pas, il y a risque que certaines pages ne soient pas indexées comme vous le souhaitez.

Bloquer l’indexation d’une page sur le moteur de recherche Bing

User-agent: bingbot

Disallow: /repertoire1/

Bloquer l’indexation d’une page sur le moteur de recherche Yahoo

User-agent: Yahoo! Slurp

Disallow: /repertoire1/

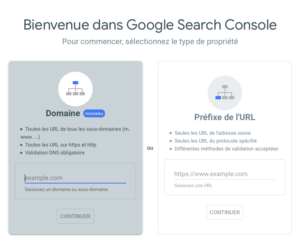

Pour vous assurer que votre fichier robots.txt est optimisé pour les moteurs de recherche, vous pouvez le tester dans la Search Console Google. La Search Console Google est un outil gratuit qui vous permet de voir comment les moteurs de recherche interprètent votre fichier robots.txt et vous donne des informations sur les erreurs d’indexation éventuelles.

Pour tester votre fichier robots.txt, connectez-vous à la Search Console Google.

Choisissez la propriété (votre site web). Entrez l’URL de votre site dans la barre d’adresse, puis cliquez sur « Tester ».

Si vous ne voyez aucune erreur, cela signifie que votre fichier robots.txt est optimisé pour les moteurs de recherche. Si vous voyez des erreurs, corrigez-les et testez à nouveau jusqu’à ce que vous obteniez une page verte « Succès ».

Avant de faire vos tests, vérifiez bien que la version du fichier robots.txt qui s’affiche à l’écran correspond bien à la version du robots.txt présent sur votre site web.

FAQ

[wp-faq-schema accordion=1]